In the fast-paced world of artificial intelligence, where yesterday’s breakthroughs quickly become today’s basics, Infrrd has done what others only dream of—cracked the code to making AI teach itself. We’re not just pushing boundaries; we’re erasing them entirely with our revolutionary approach towards Prompt Tuning.

Forget the hype and empty promises—LLMs have long been plagued by inconsistency and inaccuracies, often spitting out responses that sound convincing but fall flat on facts. It’s a phenomenon less widely known as “hallucination,” and it’s been a thorn in the side of AI developers everywhere. But that’s where Infrrd steps in—leading the charge with a game-changing solution that redefines how LLMs learn, adapt, and deliver results. Before getting deeper, let’s clear the basics first.

In der schnelllebigen Welt der künstlichen Intelligenz, in der die Durchbrüche von gestern schnell zu den Grundlagen von heute werden, hat Infrrd das getan, wovon andere nur träumen — den Code geknackt, damit sich KI von selbst beibringt. Mit unserem revolutionären Ansatz für Prompt Tuning verschieben wir nicht nur Grenzen, sondern beseitigen sie vollständig.

Vergessen Sie den Hype und die leeren Versprechungen — LLMs sind seit langem von Inkonsistenzen und Ungenauigkeiten geplagt und geben oft Antworten aus, die überzeugend klingen, aber den Fakten nicht entsprechen. Es ist ein Phänomen, das weniger bekannt ist als“Halluzination„, und es war KI-Entwicklern auf der ganzen Welt ein Dorn im Auge. Aber hier kommt Infrrd ins Spiel und führt das Unternehmen mit einer wegweisenden Lösung an, die neu definiert, wie LLMs lernen, sich anpassen und Ergebnisse liefern. Bevor wir näher darauf eingehen, sollten wir uns zunächst mit den Grundlagen vertraut machen.

Was ist Prompt Tuning?

Stellen Sie sich vor, Sie stimmen ein Musikinstrument so, dass es die perfekte Tonhöhe erreicht — nun, Prompt Tuning funktioniert für KI genauso. Anstatt ein ganzes Sprachmodell von Grund auf neu zu trainieren (was so ist, als würde man versuchen, eine Engine neu aufzubauen), werden die „Prompts“ (die Fragen oder Anweisungen, die wir der KI geben) optimiert, um sicherzustellen, dass sie die genauesten und relevantesten Antworten liefert. Stellen Sie sich vor, die perfekte Frage zu erstellen, um die präziseste Antwort der KI zu erhalten — und sie intelligenter, schneller und weitaus zuverlässiger zu machen. Es ist eine wegweisende Abkürzung, die normale KI in ein fein abgestimmtes Kraftpaket verwandelt, ohne die hohen Kosten, bei Null anzufangen!

Die Idee hinter Prompt Tuning ist einfach: Optimieren Sie die Art und Weise, wie Prompts (die Anweisungen oder Abfragen) erstellt werden, sodass das LLM die genaueste, relevanteste und genaueste Ausgabe liefert. Diese Methode kann das berüchtigte Problem der „Halluzination“, bei dem Modelle überzeugend klingende, aber falsche Antworten generieren, erheblich reduzieren.

Im Wesentlichen ermöglicht uns Prompt Tuning, mit weniger mehr zu erreichen und die Genauigkeit zu verbessern, ohne dass umfangreiche Umschulungen oder umfangreiche Datensätze erforderlich sind. Dies macht es zu einem unglaublich wichtigen Durchbruch für Anwendungen, bei denen Präzision entscheidend ist.

Aber warum ist Prompt Tuning wichtig?

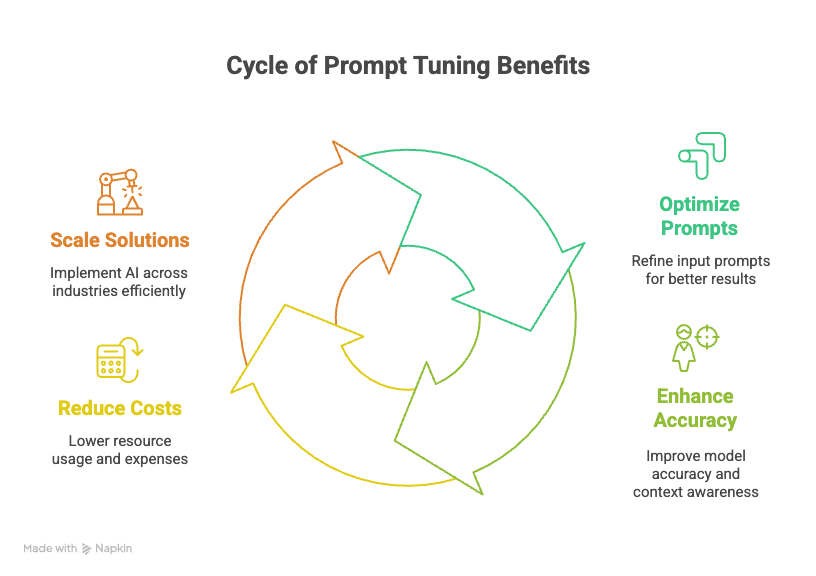

Prompt Tuning ist ein Durchbruch in der KI, da es mehrere zentrale Herausforderungen des maschinellen Lernens und der Verarbeitung natürlicher Sprache angeht:

- Verbesserte Genauigkeit: Durch die Optimierung der Eingabeaufforderungen werden die Modelle genauer und kontextsensitiver, wodurch Fehler wie Halluzinationen reduziert werden.

- Kosteneffektiv: Im Gegensatz zum vollständigen Nachtrainieren von Modellen ist Prompt Tuning weitaus weniger ressourcenintensiv und erfordert nur geringfügige Anpassungen an der Eingabe, anstatt große Datensätze oder eine leistungsstarke Computerinfrastruktur.

- Skalierbarkeit: Diese Technik ermöglicht die Implementierung von KI-Lösungen in verschiedenen Branchen, ohne dass maßgeschneiderte Modelle erforderlich sind, deren Entwicklung oft zeitaufwändig und kostspielig ist.

- Zeiteffizienz: Es ermöglicht Unternehmen, KI-Anwendungen schnell mit verbesserter Genauigkeit und Konsistenz bereitzustellen und so den Zeitaufwand für manuelle Eingriffe zu reduzieren.

Wie Prompt Tuning die Regeln neu schreibt

Bei Prompt Tuning geht es nicht darum, riesige Modelle endlos neu zu trainieren. Es geht darum, die Struktur der Prompts zu optimieren, um die bestmöglichen Antworten von vorab trainierten LLMs zu erhalten. Anstatt ganze Architekturen zu überarbeiten, konzentrieren wir uns auf die Optimierung der Eingaben. Dadurch werden die Modelle präziser und weniger anfällig für diese berüchtigten Halluzinationen.

Es gibt zwei Haupttypen von Prompt Tuning:

- Harte Prompt-Optimierung: Manuelles Erstellen und Verfeinern von Eingabeaufforderungen unter Verwendung von Fachwissen und spezifischen Aufgabenanforderungen.

- Soft-Prompt-Tuning: Durch den Einsatz trainierbarer Einbettungen, die durch Backpropagation optimiert wurden, kann das Modell die effektivsten Prompts ermitteln, ohne seine Kernstruktur zu verändern.

Durch die Nutzung von Prompt Tuning minimieren wir die Abhängigkeit von riesigen Datensätzen und eliminieren die ständige Notwendigkeit menschlicher Anpassungen. Es handelt sich um eine dynamische und anpassungsfähige Methode, die die Leistung von LLMs verändert und sie für spezielle Anwendungen zuverlässiger macht.

Die wahre Herausforderung beim Prompt Tuning — LLM Accuracy

Large Language Models (LLMs) haben unzählige Branchen revolutioniert und Aufgaben automatisiert, die das Verstehen und Generieren von Sprachen erfordern. Doch trotz ihres unbestreitbaren Potenzials haben sie ein eklatantes Problem: Sie neigen dazu, ungenaue, irreführende oder geradezu unsinnige Ergebnisse zu produzieren. Diese Inkonsistenz wird besonders problematisch, wenn es um komplexe, halbstrukturierte oder unstrukturierte Dokumente geht, bei denen selbst kleine Fehler zu erheblichen Risiken führen können.

Herkömmliche Methoden zur Behebung dieser Ungenauigkeiten erfordern oft umfangreiche menschliche Eingriffe — akribisches, zeitnahes Engineering, endlose manuelle Anpassungen und kontinuierliche Überwachung. Dieser praktische Ansatz kann zwar die Genauigkeit bis zu einem gewissen Grad verbessern, ist aber alles andere als skalierbar und definitiv nicht nachhaltig. Die Branche hat nach einer intelligenteren, autonomeren Lösung geschrien. Hier kommt der revolutionäre Prompt Tuning-Ansatz von Infrrd ins Spiel.

Das bahnbrechende multiagentische Framework von Infrard

Während sich die meisten noch mit grundlegenden Anpassungen der Eingabeaufforderung auseinandersetzen, ist Infrrd noch einen Schritt weiter gegangen. Unser Multiagentisches Framework nutzt Prompt Tuning, um ein selbstlernendes, sich selbst verbesserndes KI-Ökosystem zu schaffen. Dieser Ansatz verwendet mehrere LLMs, die kontinuierlich interagieren und voneinander lernen, wodurch der Bedarf an menschlichem Eingreifen drastisch reduziert wird.

Wichtige Innovationen im Framework von Infrrd:

- Auf Aufgaben spezialisierte Agenten: Maßgeschneiderte Agenten erledigen je nach Komplexität spezifische Aufgaben, von einfachen Operationen bis hin zu fortgeschrittenen Denk- und Programmieraufgaben.

- Automatisierte Regeloptimierung: Identifiziert dynamisch die am besten geeigneten Regeln, indem mehrere LLMs verwendet werden, um sich an unterschiedliche Datenstrukturen anzupassen.

- Behandlung vom Entitätstyp: Unterscheidet präzise zwischen ähnlichen Objekten, reduziert falsche Treffer und verbessert die Präzision.

- Übermäßige Schadensbegrenzung: Stellt sicher, dass das Modell nicht zu stark angepasst wird, indem genau zwischen echten Negativen und falsch positiven Ergebnissen unterschieden wird.

- Kontinuierliche Feedback-Schleife: Das System passt sich ohne menschliches Eingreifen selbst an und sorgt so für langfristige Genauigkeit und Konsistenz.

Auswirkungen auf die reale Welt

Wir haben dieses innovative Framework mit einigen der größten Namen der Branche getestet. Die Ergebnisse waren einfach beeindruckend — die Genauigkeitsraten stiegen sprunghaft an, als sich das System durch kontinuierliches Lernen weiterentwickelte. Wir stießen jedoch auf einige Herausforderungen:

- Ground Truth ist im Kontext nicht präsent: Manchmal wurden die Daten unterschiedlich dargestellt (z. B. Pfund im Vergleich zu Pfund), was eine genaue Extraktion schwierig machte.

- Niedriges Vorkommen der Entität: Felder mit überwiegend leeren Daten (> 90%) behinderten die effektive Regelbildung.

- Eingeschränkte Datenverfügbarkeit: Die Ausführung der Regeloptimierung mit unzureichenden Daten garantierte keine robuste Genauigkeit.

Trotz dieser geringfügigen Rückschläge wurden Bereiche, in denen die Genauigkeit verbessert wurde, einer weiteren Bewertung und Feinabstimmung unterzogen — ein Beweis für die kontinuierliche Lern- und Anpassungsfähigkeit des Systems.

Warum Prompt Tuning die KI grundlegend verändert: Entdecke die überraschenden Wahrheiten

1. Bekämpfung von Halluzinationen für zuverlässige KI-Ergebnisse

Eine der größten Herausforderungen für Large Language Models (LLMs) ist das Problem der Halluzinationen — wenn KI scheinbar genaue, aber sachlich falsche Informationen generiert. Hier kommt Prompt Tuning ins Spiel, das diese Halluzinationen nachweislich drastisch reduziert und KI-Antworten sachlicher und vertrauenswürdiger macht. EIN studieren von Stanfords AI Lab zeigte, dass diese Technik Fehler erheblich minimiert und die Zuverlässigkeit von KI-generierten Inhalten verändert.

2. Von starren Regeln zum dynamischen Lernen:

Vorbei sind die Zeiten der mühsamen Erstellung statischer Eingabeaufforderungen. Prompt Tuning treibt die KI dazu, sich über starre, regelbasierte Ansätze hinaus zu entwickeln, indem sie es ihr ermöglicht, zu „lernen“, Eingaben effizienter zu strukturieren. Untersuchungen haben gezeigt, dass dieses adaptive Lernmodell das traditionelle Prompt-Engineering übertrifft und intelligentere KI hervorbringt, die sich kontinuierlich verbessert.

3. Ressourcen sparen, Leistung steigern:

Warum ein ganzes Modell neu trainieren, wenn Sie bestehende optimieren können? Prompt Tuning ist ein Durchbruch in der Ressourcenoptimierung und ermöglicht es KI-Modellen, die Leistung von KI-Modellen um bis zu 30% zu verbessern, ohne dass zusätzliches Datentraining erforderlich ist. Forscher fanden dass dieser Ansatz die Rechenkosten drastisch senkt und den Prozess für Entwickler und Unternehmen gleichermaßen rationalisiert.

4. Freischaltung sich selbst verbessernder KI-Systeme:

Stellen Sie sich eine KI vor, die sich nicht nur im Laufe der Zeit verbessert, sondern dies auch autonom tut, mit minimaler menschlicher Aufsicht. Das ist die Stärke von Prompt Tuning. Da KI ihr schnelles Verständnis verfeinert, wird sie bei der Bearbeitung komplexer Abfragen immer effektiver.

5. Transformation von Branchen mit Präzision und Geschwindigkeit:

Die Wirkung von Prompt Tuning geht über grundlegende Aufgaben hinaus — es definiert neu, wie Branchen wie Gesundheitswesen, Finanzen und Recht mit kritischen Anwendungen umgehen. Im Finanzwesen wurde beispielsweise bei ersten Versuchen mit Prompt Tuning die Bearbeitungszeit von Krediten um 25% reduziert, was auf die Fähigkeit zurückzuführen ist, hochpräzise, maßgeschneiderte Prompts zu generieren. Dies bedeutet eine schnellere und zuverlässigere Entscheidungsfindung in allen Sektoren.

Also, was kommt als Nächstes beim Prompt Tuning?

Prompt Tuning stellt einen großen Fortschritt in der KI-Technologie dar und bietet eine Lösung für viele der aktuellen Einschränkungen von LLMs. Von der Reduzierung von Ungenauigkeiten über die Verbesserung der Effizienz bis hin zur Entwicklung sich selbst verbessernder Systeme — diese Technik prägt die Zukunft der künstlichen Intelligenz. Die Innovation von Infrrd in diesem Bereich setzt neue Maßstäbe, und während wir diese Technologien weiterentwickeln, sind die Möglichkeiten, die KI erreichen kann, endlos.

Der beste Teil? Infrrd ist bereits federführend dabei, das Konzept des KI-Unterrichts an sich in die Realität umzusetzen. Mit Prompt Tuning verbessern wir nicht nur die Funktionsweise von KI, wir erschließen auch neue Dimensionen von Effizienz, Genauigkeit und Skalierbarkeit, die Branchen verändern werden.

Erleben Sie die Zukunft des Autonomen KI mit Infrarot—wo Maschinen sich selbst etwas beibringen und die Genauigkeit niemals beeinträchtigt wird.

Häufig gestellte Fragen

Software zur Überprüfung und Prüfung von Hypotheken ist ein Sammelbegriff für Tools zur Automatisierung und Rationalisierung des Prozesses der Kreditbewertung. Es hilft Finanzinstituten dabei, die Qualität, die Einhaltung der Vorschriften und das Risiko von Krediten zu beurteilen, indem sie Kreditdaten, Dokumente und Kreditnehmerinformationen analysiert. Diese Software stellt sicher, dass Kredite den regulatorischen Standards entsprechen, reduziert das Fehlerrisiko und beschleunigt den Überprüfungsprozess, wodurch er effizienter und genauer wird.

KI verwendet Mustererkennung und Natural Language Processing (NLP), um Dokumente genauer zu klassifizieren, selbst bei unstrukturierten oder halbstrukturierten Daten.

Wählen Sie eine Software, die fortschrittliche Automatisierungstechnologie für effiziente Audits, leistungsstarke Compliance-Funktionen, anpassbare Audit-Trails und Berichte in Echtzeit bietet. Stellen Sie sicher, dass sie sich gut in Ihre vorhandenen Systeme integrieren lässt und Skalierbarkeit, zuverlässigen Kundensupport und positive Nutzerbewertungen bietet.

Audit Quality Control (QC) ist für Hypothekenunternehmen von entscheidender Bedeutung, um die Einhaltung gesetzlicher Vorschriften sicherzustellen, Risiken zu reduzieren und das Vertrauen der Anleger zu wahren. Es hilft dabei, Fehler, Betrug oder Unstimmigkeiten zu erkennen und zu korrigieren und so rechtliche Probleme und Zahlungsausfälle zu vermeiden. QC steigert auch die betriebliche Effizienz, indem Ineffizienzen aufgedeckt und die allgemeine Kreditqualität verbessert wird.

Der Einsatz von KI für QC-Audits vor der Finanzierung bietet den Vorteil, dass schnell und fehlerfrei überprüft werden kann, ob Kredite alle regulatorischen und internen Richtlinien erfüllen. KI erhöht die Genauigkeit, reduziert das Risiko von Fehlern oder Betrug, reduziert die Prüfungszeit um die Hälfte und rationalisiert den Überprüfungsprozess, sodass die Einhaltung der Vorschriften vor der Auszahlung von Geldern sichergestellt wird.

Ja, KI kann Änderungen in überarbeiteten Konstruktionszeichnungen erkennen und extrahieren und Änderungen verfolgen, um genaue Aktualisierungen in der gesamten Dokumentation sicherzustellen.